MapReduce Hadoop措施毗连数据

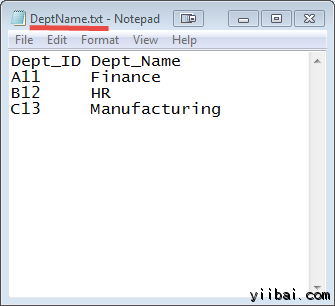

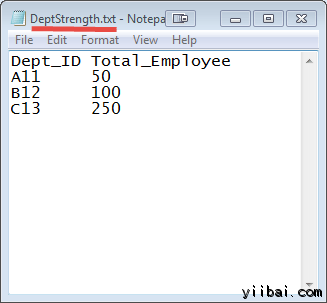

这里有两个数据荟萃在两个差异的文件中,如下所示:

DEPT_ID 键在这两个文件中常见的。

方针是利用 MapReduce 插手来组合这些文件。

输入: 我们的输入数据集是两个txt文件:DeptName.txt 和 DepStrength.txt

下载输入文件

前提条件:

在我们开始实际操纵之前,利用的用户 'hduser_'(利用 Hadoop 的用户)。

[email protected]:~$ su hduser_

步调

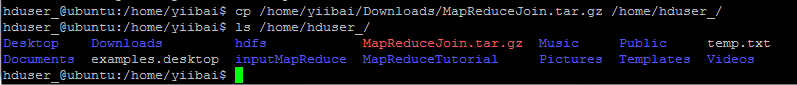

Step 1) 复制 zip 文件到您选择的位置

[email protected]:/home/yiibai$ cp /home/yiibai/Downloads/MapReduceJoin.tar.gz /home/hduser_/ [email protected]:/home/yiibai$ ls /home/hduser_/

操纵进程及功效如下:

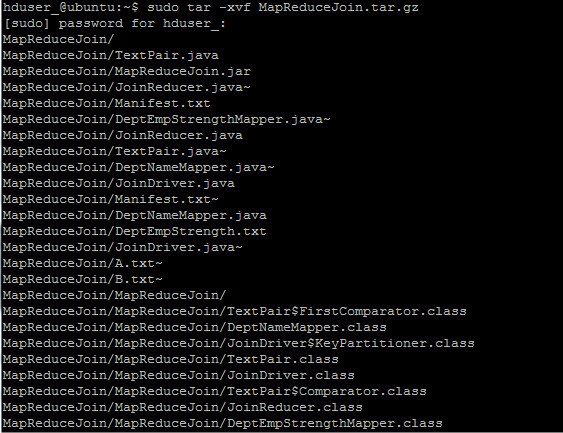

Step 2) 解压缩ZIP文件,利用以下呼吁:

[email protected]:~$ sudo tar -xvf MapReduceJoin.tar.gz

Step 3) 进入目次 MapReduceJoin/

[email protected]:~$ cd MapReduceJoin/

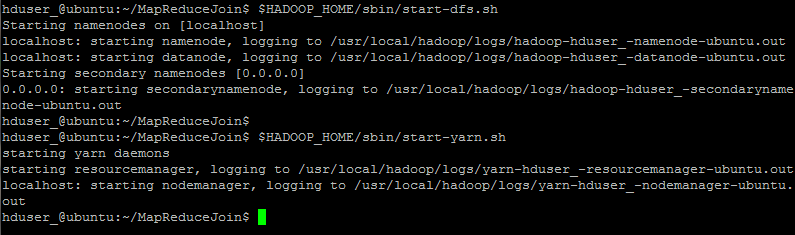

Step 4) 启动 Hadoop

[email protected]:~/MapReduceJoin$ $HADOOP_HOME/sbin/start-dfs.sh [email protected]:~/MapReduceJoin$ $HADOOP_HOME/sbin/start-yarn.sh

Step 5) DeptStrength.txt 和 DeptName.txt 用于此项目标输入文件

这些文件需要利用以下呼吁 – 复制到 HDFS 的根目次下,利用以下呼吁:

[email protected]:~/MapReduceJoin$ $HADOOP_HOME/bin/hdfs dfs -copyFromLocal DeptStrength.txt DeptName.txt /

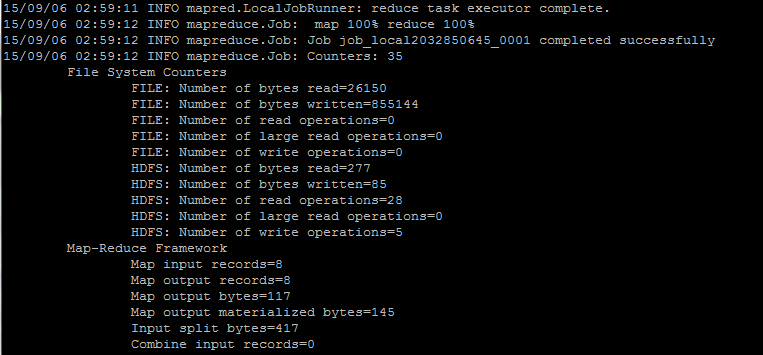

Step 6) 利用以下呼吁 – 运行措施

[email protected]:~/MapReduceJoin$ $HADOOP_HOME/bin/hadoop jar MapReduceJoin.jar /DeptStrength.txt /DeptName.txt /output_mapreducejoin

Step 7)

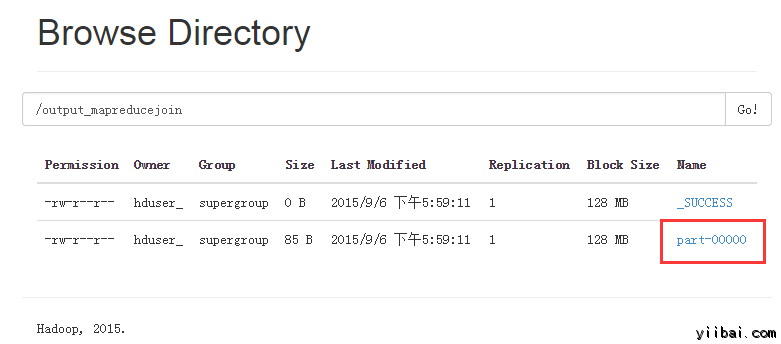

在执行呼吁后, 输出文件 (named 'part-00000') 将会存储在 HDFS目次 /output_mapreducejoin

#p#分页标题#e#

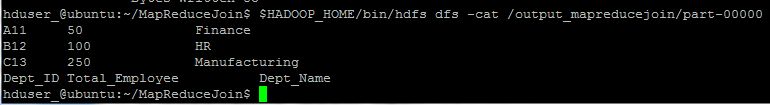

功效可以利用呼吁行界面可以看到:

[email protected]:~/MapReduceJoin$ $HADOOP_HOME/bin/hdfs dfs -cat /output_mapreducejoin/part-00000

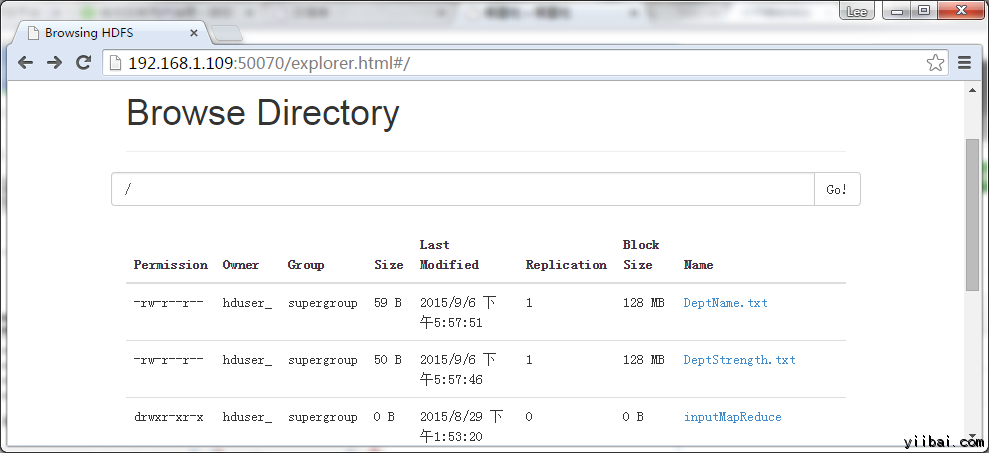

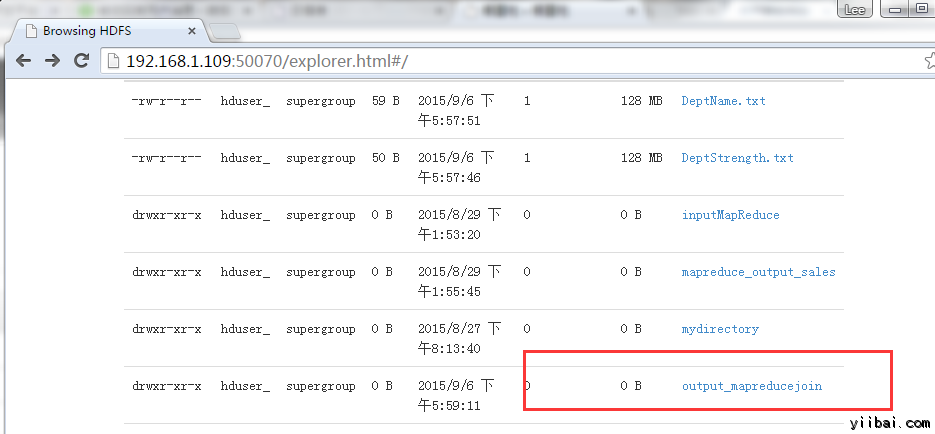

功效也可以通过 Web 界面查察(这里我的虚拟机的IP是 192.168.1.109),如下图所示:

此刻,选择 “Browse the filesystem”,并欣赏到 /output_mapreducejoin

打开 part-r-00000

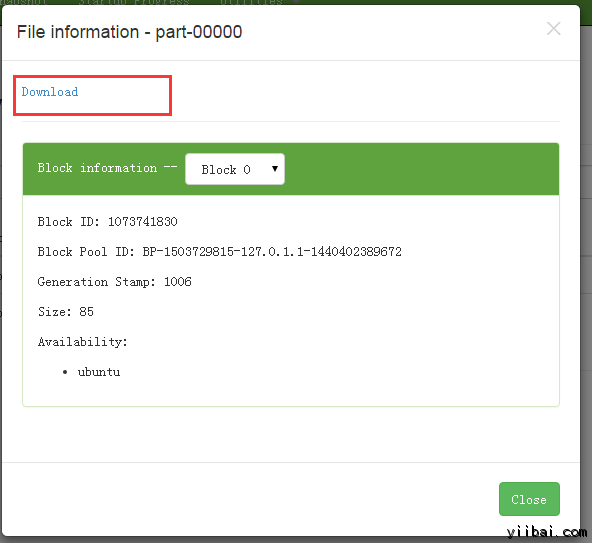

功效如下所示,点击 Download 链接下载:

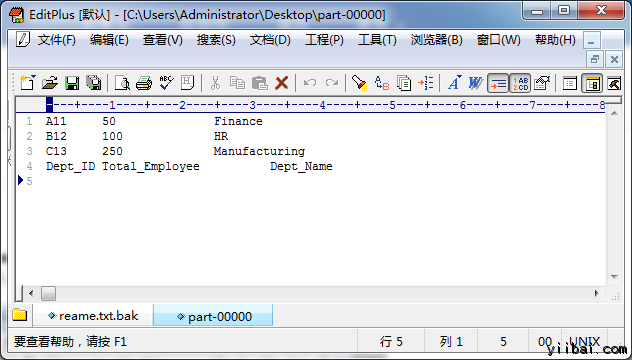

打开下载后的 文件,功效如下所示:

注:请留意,下一次运行此措施之前,需要删除输出目次 /output_mapreducejoin

$HADOOP_HOME/bin/hdfs dfs -rm -r /output_mapreducejoin

另一种要领是利用差异的名称作为输出目次。