Hadoop安装

本教程是以Ubuntu 系统作为安装讲授情况,为了淘汰不须要的贫苦,请您 安装Ubuntu 并能正常启动进入系统。同时也必需要 安装Java。

一、添加 Hadoop 系统用户组和用户

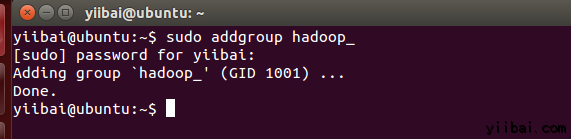

利用以下呼吁在终端中执行以下呼吁来先建设一个用户组:

[email protected]:~$ sudo addgroup hadoop_

操纵功效如下:

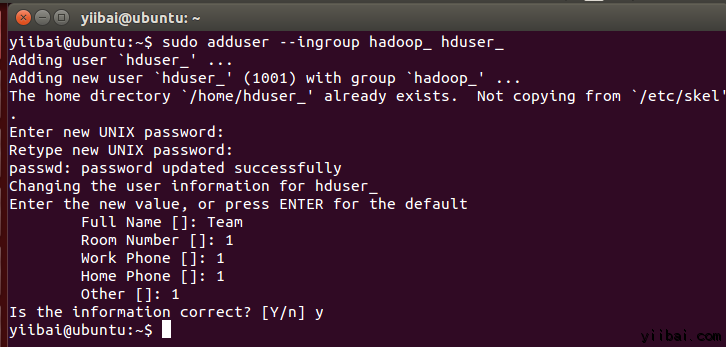

利用以下呼吁来添加用户:

[email protected]:~$ sudo adduser --ingroup hadoop_ hduser_

输入您的暗码,姓名和其他具体信息。

二、设置SSH

为了在集群打点节点,Hadoop需要SSH会见

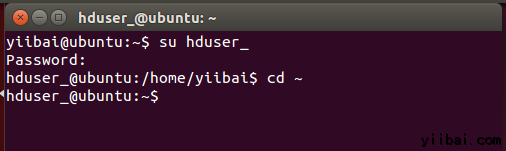

首先,切换用户,输入以下呼吁:

[email protected]:~$ su hduser_

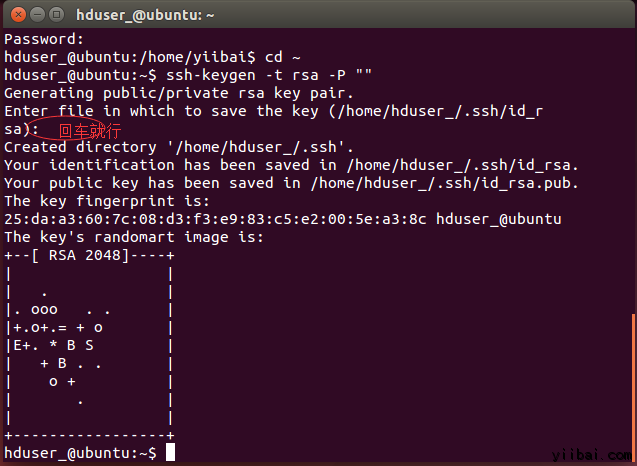

以下这个呼吁将建设一个新的密钥。

[email protected]:~$ ssh-keygen -t rsa -P ""

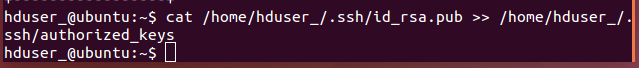

利用此密钥启用SSH会见当地计较机。

[email protected]:~$ cat /home/hduser_/.ssd/id_rsa.pub >> /home/hduser_/.ssh/authorized_keys

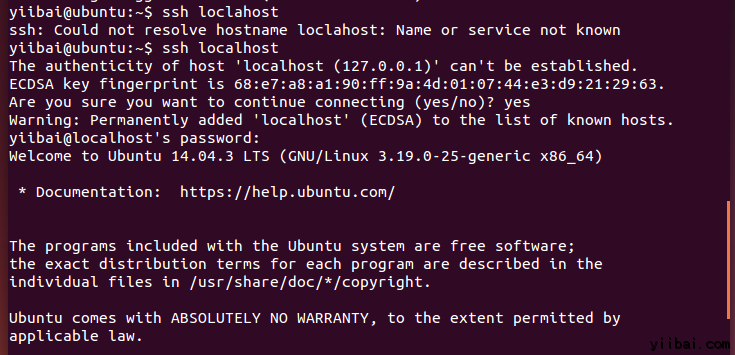

此刻,测试SSH配置通过“hduser”用户毗连到locahost。

[email protected]:~$ ssh localhost

留意:

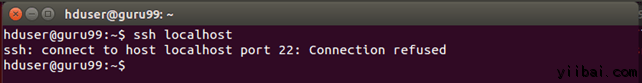

请留意,执行 'ssh localhost' 呼吁后假如看到下面的错误响应, 大概 SSH 在此系统不行用。

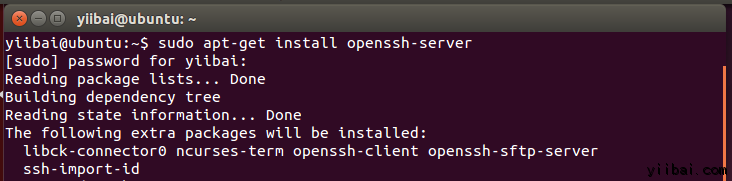

来办理上面这个问题,安装 SSH 处事 –

#p#分页标题#e#

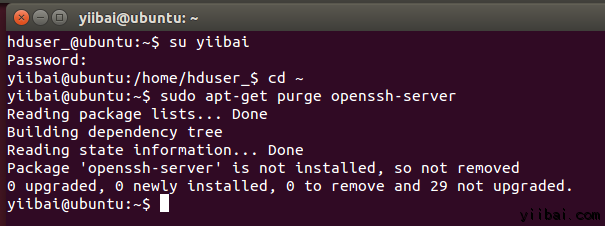

排除 SSH 利用以下呼吁:

[email protected]:~$ sudo apt-get purge openssh-server

在安装开始前排除 SSH 处事,这是一个很好的做法(发起),假如碰着“

is not in the sudoers file …“提示,请利用有sudo 的用户来执行,

这里利用的用户是:yiibai

利用以下呼吁来安装SSH,利用以下呼吁:

[email protected]:~$ sudo apt-get install openssh-server

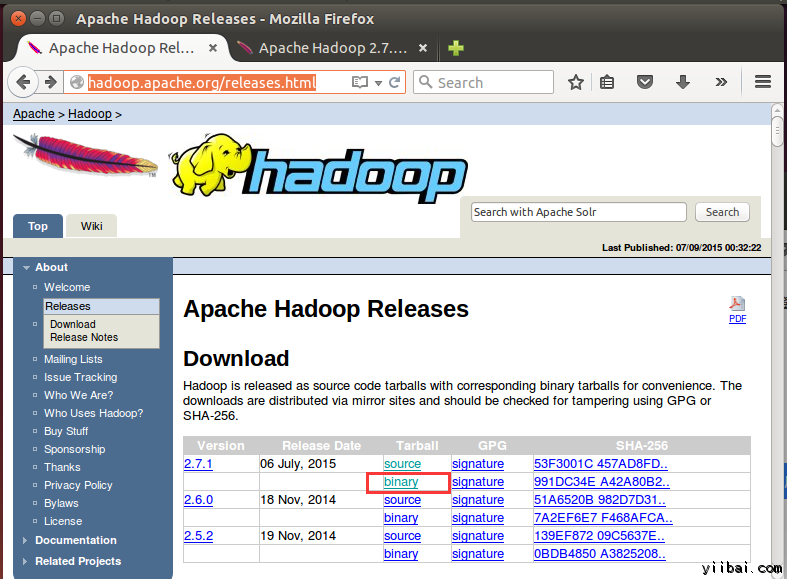

三、下载Hadoop

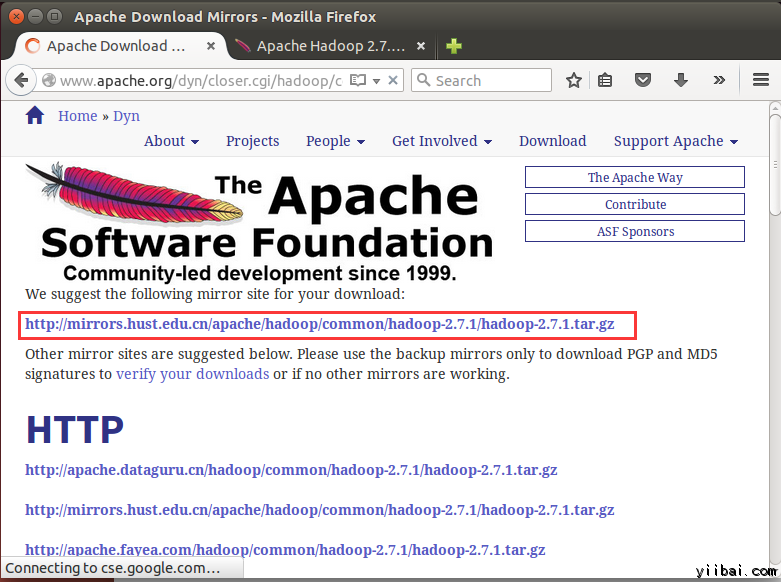

在欣赏器中打开网址:http://hadoop.apache.org/releases.html

选择一个最新 2.7.1 的不变版本(stable)的二进制包下载,如下:

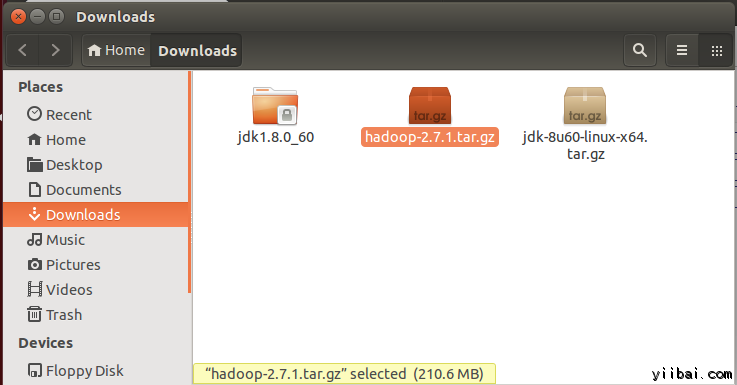

下载完成后,默认将文件放在 /home/yiibai/Downloads,如下图所示:

此刻进入到到包括tar文件的目次,筹备解压 tar.gz 文件:

[email protected]:~$ cd /home/yiibai/Downloads

利用以下呼吁解压文件包:

[email protected]:~$ sudo tar xzf hadoop-2.7.1.tar.gz

此刻重定名 hadoop-2.2.0 为 hadoop

[email protected]:~$ sudo mv hadoop-2.7.1 /usr/local/hadoop

变动文件用户属性,执行以下呼吁:

[email protected]:~$ cd /usr/local [email protected]:~$ sudo chown -R hduser_:hadoop_ hadoop

到这里,hadoop文件的相关事情已经筹备好,接下来我们还要做一些要害的配置。

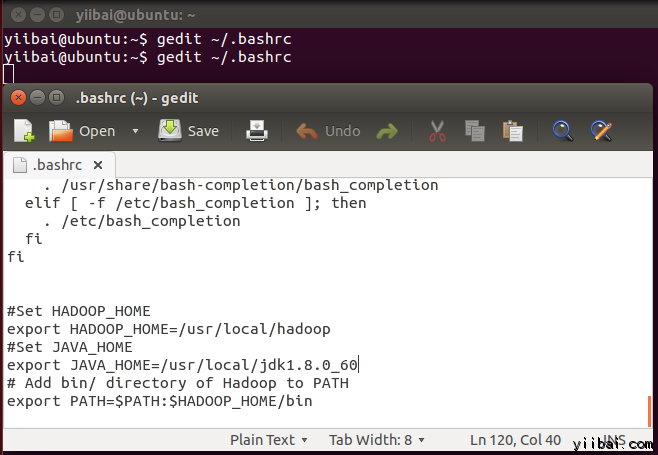

四、修改 ~/.bashrc 文件

添加以下这些行到 ~/.bashrc 文件的末端,内容如下所示:

|

1 2 3 4 5 6 |

#Set HADOOP_HOME export HADOOP_HOME=/usr/local/hadoop #Set JAVA_HOME export JAVA_HOME=/usr/local/jdk1.8.0_60 # Add bin/ directory of Hadoop to PATH export PATH=$PATH:$HADOOP_HOME/bin |

#p#分页标题#e#

在终端下执行以下呼吁,打开编辑器并将上面的内容插手到文件的底部,如下图所示:

[email protected]:~$ vi ~/.bashrc

此刻,利用下面的呼吁情况设置

[email protected]:~$ . ~/.bashrc

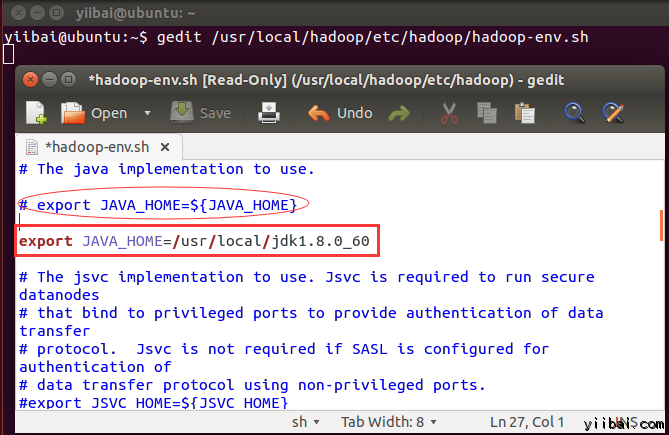

五、设置关联HDFS

配置 JAVA_HOME 在文件 /usr/local/hadoop/etc/hadoop/hadoop-env.sh 中,利用以下行取代,即写上完整的 Java 安装路径。如下所示:

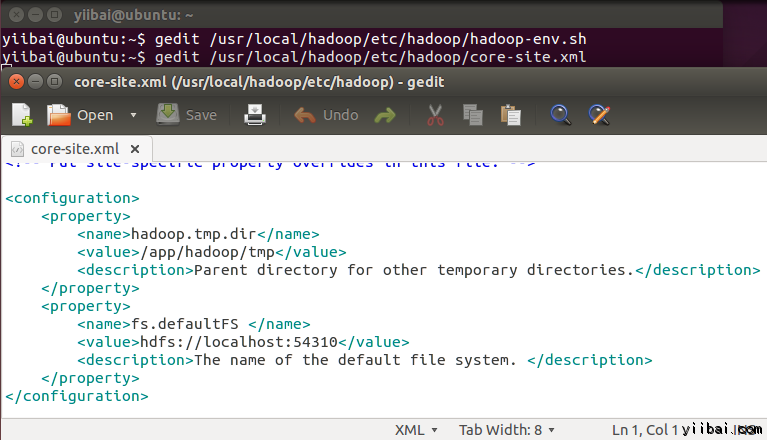

在 $HADOOP_HOME/etc/hadoop/core-site.xml 文件中尚有两个参数需要配置:

1. 'hadoop.tmp.dir' – 用于指定目次让 Hadoop 来存储其数据文件。

2. 'fs.default.name' – 指定默认的文件系统

为了配置两个参数,打开文件 core-site.xml

[email protected]:~$ sudo gedit /usr/local/hadoop/etc/hadoop/core-site.xml

拷贝以下所有行的内容放入到标签 <configuration></configuration> 中间。

|

1 2 3 4 5 6 7 8 9 10 |

<property> <name>hadoop.tmp.dir</name> <value>/app/hadoop/tmp</value> <description>Parent directory for other temporary directories.</description> </property> <property> <name>fs.defaultFS </name> <value>hdfs://localhost:54310</value> <description>The name of the default file system. </description> </property> |

功效如下图所示:

进入到目次:/usr/local/hadoop/etc/hadoop,利用如下的呼吁:

[email protected]:~$ cd /usr/local/hadoop/etc/hadoop [email protected]:/usr/local/hadoop/etc/hadoop$

#p#分页标题#e#

此刻建设一个目次,如上面设置 core-site.xml 中利用的目次:/app/hadoop/tmp

[email protected]:/usr/local/hadoop/etc/hadoop$ sudo mkdir -p /app/hadoop/tmp

授予权限目次 /app/hadoop/tmp,执行如下的呼吁:

[email protected]:~$ sudo chown -R hduser_:hadoop_ /app/hadoop/tmp [email protected]:~$ sudo chmod 750 /app/hadoop/tmp

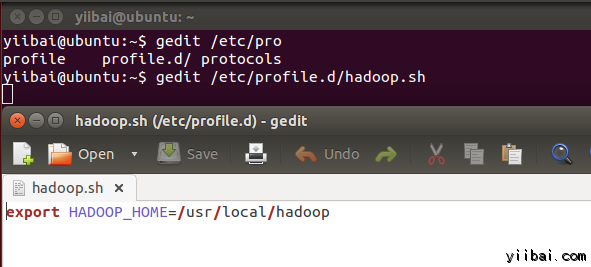

六、Map Reduce 设置

在配置这个设置之前, 我们需要配置 HADOOP_HOME 的路径,执行以下呼吁:

[email protected]:~$ sudo gedit /etc/profile.d/hadoop.sh

然后输入以下一行,

export HADOOP_HOME=/usr/local/hadoop

再执行以下呼吁:

[email protected]:~$ sudo chmod +x /etc/profile.d/hadoop.sh

退出呼吁行终端再次进入,并输入以下呼吁:echo $HADOOP_HOME 以验证 hadoop 的路径:

[email protected]:~$ echo $HADOOP_HOME /usr/local/hadoop

此刻复制文件,执行以下呼吁:

[email protected]:~$ sudo cp $HADOOP_HOME/etc/hadoop/mapred-site.xml.template $HADOOP_HOME/etc/hadoop/mapred-site.xml

利用vi 打开文件 mapred-site.xml

[email protected]:~$ sudo vi $HADOOP_HOME/etc/hadoop/mapred-site.xml

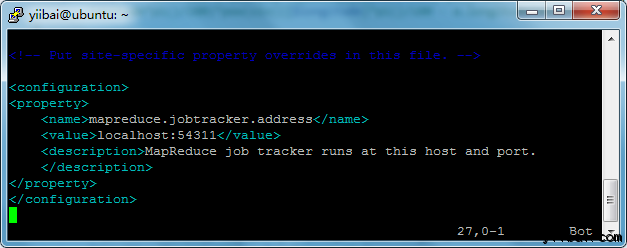

添加以下的配置内容到标签<configuration> 和 </configuration> 中,如下图所示:

|

1 2 3 4 5 6 |

<property> <name>mapreduce.jobtracker.address</name> <value>localhost:54311</value> <description>MapReduce job tracker runs at this host and port. </description> </property> |

打开 $HADOOP_HOME/etc/hadoop/hdfs-site.xml 文件如下:

[email protected]:~$ sudo vi $HADOOP_HOME/etc/hadoop/hdfs-site.xml

#p#分页标题#e#

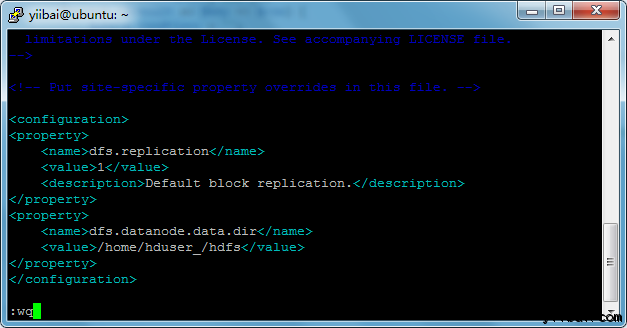

添加以下的配置内容到标签<configuration> 和 </configuration> 中,如下图所示:

|

1 2 3 4 5 6 7 8 9 |

<property> <name>dfs.replication</name> <value>1</value> <description>Default block replication.</description> </property> <property> <name>dfs.datanode.data.dir</name> <value>/home/hduser_/hdfs</value> </property> |

建设以上设置指定的目次并授权目次给用户,利用以下呼吁:

[email protected]:~$ sudo mkdir -p /home/hduser_/hdfs [email protected]:~$ sudo chown -R hduser_:hadoop_ /home/hduser_/hdfs [email protected]:~$ sudo chmod 750 /home/hduser_/hdfs

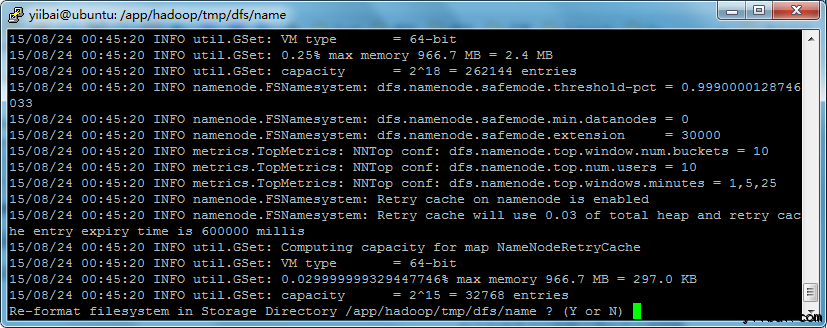

七、名目化HDFS

在第一利用 Hadoop 之前,需要先名目化 HDFS,利用下面的呼吁

[email protected]:~$ $HADOOP_HOME/bin/hdfs namenode -format

执行功效如下图所示:

输入:y,继往下…

注:大概会碰着一些提示错误:“java.io.IOException: Cannot create directory /app/hadoop/tmp/dfs/name/current…”,请执行以下呼吁来建设目次:

[email protected]:~$ sudo mkdir -p /app/hadoop/tmp/dfs/name/current [email protected]:~$ sudo chmod -R a+w /app/hadoop/tmp/dfs/name/current/

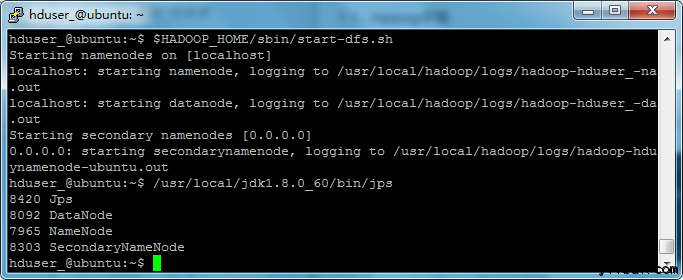

八、 启动 Hadoop 的单节点集群

利用以下呼吁启动cHadoop 的单节点集群(利用 hduser_ 用户来启动),如下:

[email protected]:~$ $HADOOP_HOME/sbin/start-dfs.sh

上面的呼吁输出功效如下所示:

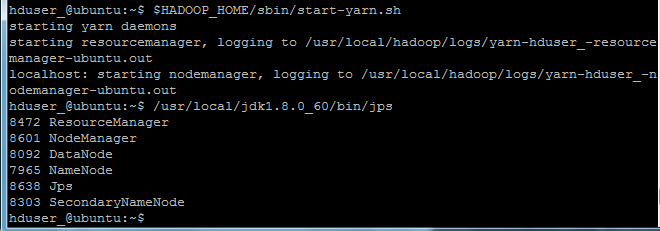

接下来再执行呼吁:

[email protected]:~$ $HADOOP_HOME/sbin/start-yarn.sh

此刻利用 'jps' 东西/呼吁, 验证是否所有 Hadoop 相关的历程正在运行。

[email protected]:~$ /usr/local/jdk1.8.0_60/bin/jps

假如 Hadoop 乐成启动,那么 jps 输出应显示: NameNode, NodeManager, ResourceManager, SecondaryNameNode, DataNode.

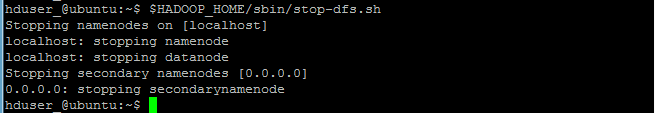

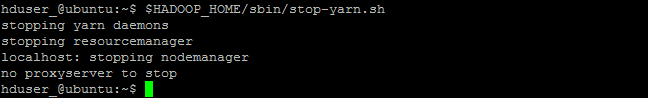

九、遏制/封锁 Hadoop

[email protected]:~$ $HADOOP_HOME/sbin/stop-dfs.sh

[email protected]:~$ $HADOOP_HOME/sbin/stop-yarn.sh

the end.