参加:黄小天、蒋思源

今天,机器之心小编在 Github 上发现了一个良心项目:RedditSota 计算了各种机器学习使命的最尖端研讨成果(论文),方便大家索引查阅。机器之心对此项目做了介绍。

该 GitHub 库供给了一切机器学习问题的当时最优成果,并尽最大努力保证该库是最新的。假如你发现某个问题的当时最优成果已过时或丢失,请作为问题提出来(顺便:论文称号、数据集、方针、源代码、年份),咱们会立即更正。

NLP

-

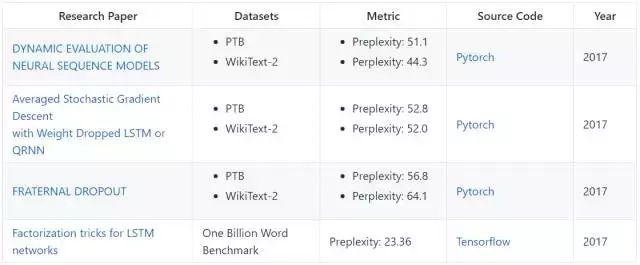

以下展现了言语建模方面当时顶尖的研讨成果及它们在不同数据集上的功能。

-

论文:

-

论文:Learning Structured Text Representations

-

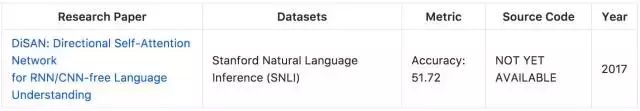

4、自然言语推理

-

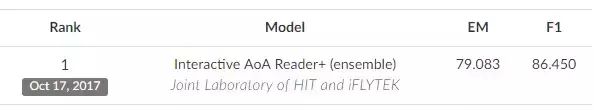

论文:Interactive AoA Reader+ (ensemble)

-

1、分类

-

论文:THE MICROSOFT 2017 CONVERSATIONAL SPEECH RECOGNITION SYSTEM

- <p font-size:16px;background-color:#ffffff;"="" style="word-wrap: break-word; font-family: "sans serif", tahoma, verdana, helvetica; font-size: 12px; white-space: normal; color: rgb(26, 26, 26);">英伟达在本文中描绘了一种新的 GAN 练习办法,其中心思维是一起逐渐地增加生成器与鉴别器的才能:从低分辨率开端,增加继续建模精密细节的新层作为练习进程。这不只加速了练习,并且愈加安稳,取得质量超出料想的图画。本文一起提出了一种增加生成图画变体的简洁办法,并在 CIFAR10 上取得了 8.80 的得分。别的的一个额定贡献是创立 CELEBA 数据集的更高质量版别。

论文:DYNAMIC EVALUATION OF NEURAL SEQUENCE MODELS

完结地址:https://github.com/benkrause/dynamic-evaluation

论文:Regularizing and Optimizing LSTM Language Models

完结地址:https://github.com/salesforce/awd-lstm-lm

论文:FRATERNAL DROPOUT

完结地址:https://github.com/kondiz/fraternal-dropout

论文:Factorization tricks for LSTM networks

完结地址:https://github.com/okuchaiev/f-lm

在言语建模(Language Modelling)的四个顶尖研讨成果中,咱们看到 Yoshua Bengio 等人的研讨 FRATERNAL DROPOUT 在 PTB 和 WikiText-2 数据集上都完结了当时最好的成果。在该篇论文中,Bengio 等人提出了一项叫做 fraternal dropout 的技能,他们首要用不同的 dropout mask 对两个相同的 RNN(参数同享)进行练习,并最小化它们 (pre-softmax) 猜测的差异。这样正则项会促进 RNN 的表征对 dropout mask 具有不变性。Bengio 等人证明了他们的正则项上界为线性期望的 droupout 方针,即可以处理 droupout 因练习和推断阶段上呈现的差异而导致的 Gap。

完结地址:https://github.com/jadore801120/attention-is-all-you-need-pytorch、https://github.com/tensorflow/tensor2tensor

论文:NON-AUTOREGRESSIVE NEURAL MACHINE TRANSLATION

完结地址:未发布

在机器翻译上,咱们比较了解的就是谷歌大脑 Ashish Vaswani 等人关于注意力机制的研讨,该模型在 WMT 2014 英法和英德数据集上都有十分不错的体现。该研讨标明在编码器-解码器装备中,显性序列显性转导模型(dominant sequence transduction model)根据杂乱的 RNN 或 CNN。体现最佳的模型也需经过注意力机制(attention mechanism)衔接编码器和解码器。因而谷歌在该篇论文中提出了一种新式的简略网络架构——Transformer,它完全根据注意力机制,完全放弃了循环和卷积。上图两项机器翻译使命的试验也标明这些模型的翻译质量不只十分优异,一起它们更能并行处理,因而这种模型所需的练习时刻也能大大削减。这篇论文标明 Transformer 在其他使命上也泛化很好,能成功应用到有很多练习数据和有限练习数据的英语组别剖析使命上。

完结地址:未发布

论文:Attentive Convolution

完结地址:未发布

爱丁堡大学的 Yang Liu 等人提出了学习结构化的文本表征,在这篇论文中,他们重视于在没有语篇解析或额定的标示资源下从数据中学习结构化的文本表征。尽管现在暂时还没有相应的完结代码,不过他们在 Yelp 数据集上准确度能到达 68.6。而另一篇带注意力的卷积提出了了一种 AttentiveConvNet,它经过卷积操作扩展了文本处理的视界。

论文地址:https://arxiv.org/pdf/1709.04696.pdf

完结地址:未发布

斯坦福问答数据集(SQuAD)是一个新式阅览了解数据集,该数据集中的问答是根据维基百科并由众包的方式完结的。小编并没有找到该论文,如下 GitHub 地址给出的是该数据集和评估该数据集的模型。

论文地址:https://arxiv.org/pdf/1710.11027.pdf

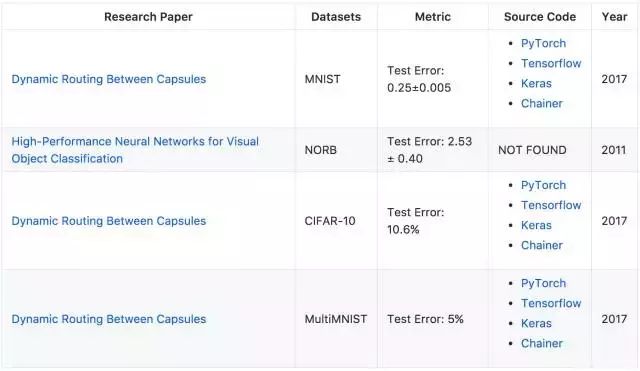

论文地址:https://arxiv.org/pdf/1710.09829.pdf

论文地址:https://arxiv.org/pdf/1102.0183.pdf

此外,Jurgen Schmidhuber 等人提出了一种视觉方针分类的高功能神经网络,在该论文中他们提出了一种卷积神经网络变体的快速全可参数化的 GPU 完结。尽管该论文是在 2011 年提出的,不过它在 NORB 数据集上仍是有十分不错的作用。

语音

完结地址:未发布

本文介绍了微软对话语音辨认体系的 2017 版别。它在原有的模型架构设置中增加了一个 CNN-BLSTM 声学模型,并且在体系结合之后还增加了一个混合网络再打分的进程。成果这一体系在数据集 Switchboard Hub5'00 上取得了 5.1% 的词错率。

半监督学习

计算机视觉

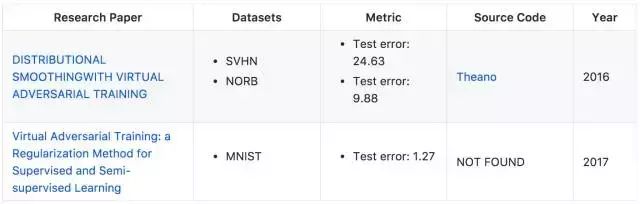

论文地址:https://arxiv.org/pdf/1507.00677.pdf

论文地址:https://arxiv.org/pdf/1704.03976.pdf

第二篇论文提出了一种根据虚拟对立损失的新正则化办法:输出散布的部分滑润度的新丈量手段。因为滑润度模型的指示是虚拟对立的,所以这一办法又被称为虚拟对立练习(VAT)。VAT 的计算成本相对较低。本文试验在多个基准数据集上把 VAT 应用到监督和半监督学习,并在 MNIST 数据上取得了 Test Error 1.27 的优异体现。

无监督学习

计算机视觉

论文地址:http://research.nvidia.com/sites/default/files/publications/karras2017gan-paper-v2.pdf

代写CS&Finance|建模|代码|系统|报告|考试

编程类:C++,JAVA ,数据库,WEB,Linux,Nodejs,JSP,Html,Prolog,Python,Haskell,hadoop算法,系统 机器学习

金融类:统计,计量,风险投资,金融工程,R语言,Python语言,Matlab,建立模型,数据分析,数据处理

服务类:Lab/Assignment/Project/Course/Qzui/Midterm/Final/Exam/Test帮助代写代考辅导

E-mail:[email protected] 微信:BadGeniuscs 工作时间:无休息工作日-早上8点到凌晨3点

如果您用的手机请先保存二维码到手机里面,识别图中二维码。如果用电脑,直接掏出手机果断扫描。